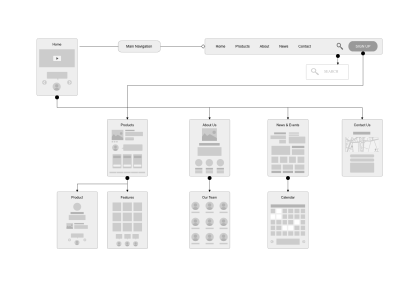

فایل robots.txt؛ دستورالعملی برای رباتهای وب

پروتکل حذف ربات که بیشتر با نام robots.txt شناخته میشود، یک دستورالعمل برای رباتها است. دستورالعملی که به آنها میگوید مجوز ورود به کدام صفحات را ندارند و در مقابل به کدام صفحات میتوانند وارد شوند. این فایل یک فایل متنی با اهمیت و کارکرد بالا برای سئو سایت است. در این مطلب با کارکرد فایل robots.txt آشنا میشویم.

اهمیت فایل robots.txt در سئو

پروتکل حذف ربات ابزاری است که سئوکاران از آن برای بهینهسازی سئو سایت استفاده میکنند. کارکرد اصلی آن در جلوگیری از دسترسی خزندههای وب به تمام یا بخشی از یک وبسایت است. این فایل، یک فایل متنی و حاوی دستوراتی برای رباتهای موتورهای جستجو بهویژه خزندههایی است صفحات متن را فهرستبندی کرده و به اصطلاح آنها را ایندکس میکنند.

در فرآیند ایندکس کردن صفحات سایت، این رباتها هم فهرستی از صفحات ایجاد میکنند و هم ارزش صفحات را یادداشت میکنند. مجموع ارزش این صفحات، یکی از مهمترین معیارها برای تعیین ارزش سایت (Site Authority) است. بنابراین ما با استفاده از فایل robots.txt میتوانیم از ایندکس شدن صفحاتی پیشگیری کنیم که دارای ارزش کمی هستند اما باید در دسترس کاربران باشند.

فایل robots.txt چگونه عمل میکند؟

موتورهای جستجو دو وظیفه اصلی دارند: خزیدن در وب برای کشف محتوا و فهرستبندی آن محتوا. این کار برای این انجام میشود که موتورهای جستجو بتوانند بنابر معیارهای تعیین شده یا همان الگوریتمهای موتور جستجو، صفحات وب را رتبهبندی کرده و آنها را بر اساس کلیدواژههای مورد جستجو، بین کاربران اینترنت توزیع کنند.

طی این فرآیند، موتورهای جستجو، رباتهایی را با نام خزندهها برای شناسایی و فهرستبندی صفحات به سراسر وب میفرستند. آنها کار خود را با جستجوی لینکها شروع میکنند و از طریق آنها وارد سایتها میشوند. همچنین از لینکهای خروجی برای یافتن سایتهای دیگر استفاده میکنند و به این شکل، میلیاردها لینک و وبسایت را بررسی و فهرستبندی میکنند.

هنگامیکه ربات موتور جستجو به یک وبسایت دسترسی پیدا میکند، به دنبال فایل robots.txt میگردد. اگر این فایل را پیدا کند، قبل از اینکه به مرور صفحات ادامه دهد، این فایل را میخواند. اگر شما در این فایل دستورالعملهایی برای منع ایندکس یا خزش ربات نوشته باشید، ربات این دستور را میپذیرد و طبق درخواست شما عمل میکند.

چرا به فایل robots.txt نیاز داریم؟

فایلهای robots.txt دسترسی ربات به مناطق خاصی از سایت شما را مدیریت میکنند. البته این نکته را هم بگوییم که اگر بهطور تصادفی رباتهای گوگل (Googlebot) را از خزیدن در کل سایت خود منع کنید، همه زحمات شما برای سئو بینتیجه میماند. با این حال استفاده صحیح از این فایل میتواند بسیار مفید باشد. برخی از موارد استفاده از فایل robots.txt را با هم مرور میکنیم.

۱- جلوگیری از ایندکس شدن صفحات

در بیشتر اوقات صفحاتی هستند که شما ترجیح میدهید توسط رباتهای موتورهای جستجو فهرستبندی نشوند. بنابراین پیشگیری از ورود رباتها به این صفحات مهمترین دلیل نوشتن فایلهای robots.txt است. برخی از این صفحات عبارتند از:

- صفحات در حال ساخت

- نتایج جستجوهای داخلی سایت

- محتواهای ایجاد شده توسط مخاطبان سایت

- صفحات فایلهای پی دی اف

- محتواهای تکراری

- برخی از تصاویر سایت

۲- مدیریت بودجه خزش توسط رباتها

فایلهای robots.txt در بهینهسازی سئو سایتهای بزرگ تاثیر بالایی دارند. اهمیت این فایلها برای این سایتها در این است که آنها دارای هزاران صفحه هستند و مدیران سایت نیازی نمیبینند همه صفحات ایندکس شوند. با نوشتن یک پروتکل منع خزش، شانس خزش در مورد صفحات مهم و دارای ارزش بیشتر افزایش مییابد. برای مثال با استفاده از این فایلها میتوانید شانس خزش صفحات فرود را افزایش دهید و سپس از طریق این صفحات به توزیع ترافیک به صفحات دیگر سایت استفاده کنید و بودجه خزش سایتتان را مدیریت کنید.

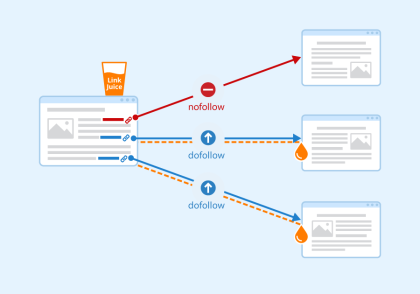

۳- مدیریت تساوی لینکها

یکی از نتایج دور نگه داشتن رباتهای جستجوگر از صفحاتی که ارزش کمتری دارند این است که جریان تساوی لینکها در صفحات فرود، بهینهسازی میشود. این ویژگی نیز شانس دریافت رتبه بهتر از سوی موتورهای جستجو را افزایش میدهد. بنابراین این صفحات، ترافیک بیشتری را نیز دریافت میکنند.

۴- ارائه آدرس نقشه سایت

یکی از کاربردهای مفید فایل robots.txt این است که آدرس نقشه سایت را در اختیار رباتها قرار میدهند. البته این یک ویژگی جانبی است زیرا از طریق سرچ کنسول گوگل نیز میتوانید همین کار را انجام دهید. با این حال قرار دادن آدرس نقشه سایت باعث افزایش اطمینان شما در این زمینه خواهد شد.

۵- ایجاد تاخیر در خزش

تاخیر در خزش راهکار مفید دیگری برای سایتهای بزرگ مانند فروشگاههای اینترنتی بزرگ است. این وبسایتها گاهی تعداد زیادی از محتواهای ایجاد شده را بهطور همزمان روی سایت قرار میدهد. بهمحض انتشار این محتواها خزندهها دست بهکار میشوند تا برای ایندکس این صفحات اقدام کنند.

این اقدامات فشار زیادی را در زمان کم روی سرور وارد میکند و نتیجه آن کاهش سرعت بارگذاری سایت است. با قرار دادن دستورالعمل تاخیر در خزش، شما میتوانید از بروز این فشار روی سرور سایت پیشگیری کنید. این یعنی رباتها صفحات جدید را با سرعت کمتری ایندکس میکنند.

چگونه یک فایل robots.txt بنویسیم؟

روش نوشتن فایل robots.txt آسان است و حتی کسانی که بر زبانهای برنامهنویسی تسلط ندارند با کمی تمرین میتوانند این فایلها را ایجاد کنند. اولین قدم برای نوشتن چنین فایلی این است که فهرستی از صفحاتی ایجاد کنید که نمیخواهید رباتهای جستجوگر به آنها وارد شوند. همچنین باید با واژگان اصلی این فایل آشنا باشید.

این واژگان عبارتند از:

- کد User-agent: ابتدا باید تعیین کنید که در حال دستور دادن به کدام رباتها هستید برای مثال برای محدود کردن رباتهای گوگل نام Googlebot و برای محدود کردن خزندههای موتور جستجوی بینگ نام Bingbot را بنویسید. علامت ستاره (*) به معنای همه رباتها میباشد.

- کد Disallow: در این بخش میتوانید آدرسهایی را قرار دهید که رباتها نباید به آنها وارد شوند. آدرسی مانند category/sample-page.html

- کد Crawl-delay: از این کد برای تاخیر در ورود و خزش توسط رباتها استفاده میشود. این تاخیر میتواند در حد چند میلیثانیه باشد اما اثر مناسبی دارد و زمان آن نیز بر اساس مقیاس سایت و ظرفیت سرور تعیین میشود

- کد Sitemap: این کد به ربات جستجو میگوید که نقشه سایت را کجا پیدا کنند

با فایل robots.txt به موتورهای جستجو فرمان دهید

بسیاری از مدیران وبسایت تصور میکنند همیشه موتورهای جستجو هستند که روی پلتفرمهای اینترنتی تسلط دارند. با این حال ابزارهایی هم وجود دارند که سایتها را قادر میسازند به موتورهای جستجو دستور دهند. از سوی دیگر بسیاری از موتورهای جستجو از جمله گوگل و بینگ، روش کار ابزارهایی مانند robots.txt را پذیرفتهاند و بنابر درخواست آنها عمل میکنند. بنابراین شما با استفاده از این فایل میتوانید با تعیین صفحاتی که نباید ایندکس شوند، به اهداف سئو سایت خود دست یابید.

دیدگاهتان را بنویسید